Технология deep fake как повод для начала войны

Новый мир с deep fake

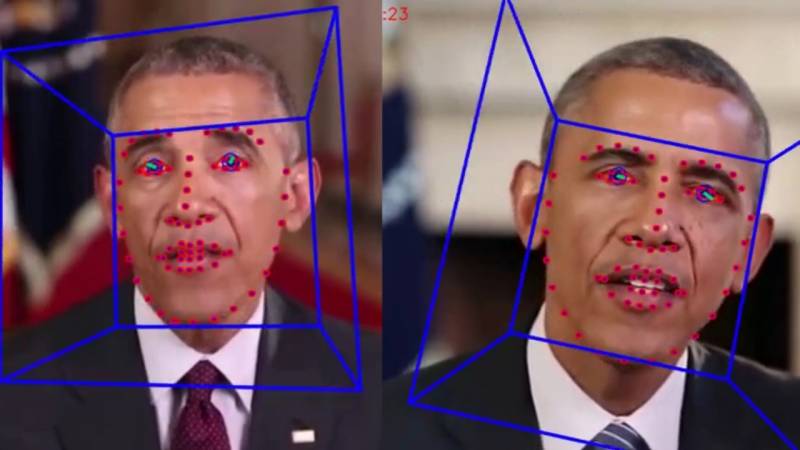

Интернет сейчас есть чуть ли не в каждом утюге, становится все сложнее найти точку на карте, где сеть 4G была бы недоступна. Широкополосный интернет – это прежде всего видео в качестве HD на распространенных платформах, которые постепенно заменяют для нас новостные ленты, аналитику и просто развлекательное чтиво. Кроме того, это инструмент влияния на миллиарды людей, позволяющий создавать нужное в данный момент общественное мнение. На пике этих игр с населением может оказаться технология deep fake, которая уже доказала свою способность превратить знаменитостей, таких, как Галь Гадот, Скарлетт Йоханссон, Тейлор Свифт, Эмма Уотсон и Кэти Перри, в звезд порноиндустрии. Дипфейк – это алгоритм, позволяющий моделировать поведение и внешность человека на видеозаписи. Имя технология получила от сочетания deep learning («глубокое обучение») и fake («подделка»). В основе deep fake лежат пресловутые нейронные сети, работающим по генеративно-состязательному принципу (Generative Adversarial Network, GAN). Алгоритмы, заложенные в базу программы, постоянно соревнуются друг с другом в двух процессах: обучение на представленных фотографиях с целью создания реальной подмены лица на копии и исключение негодных вариантов до тех пор, пока машина сама не начнет путать оригинал и копию. В этой сложной схеме заключается основная цель работы deep fake – создание ложных фотографий и видеоконтента, в которых лицо оригинала замещается другим образом. К примеру, харизматичный президент США Дональд Трамп вполне может встать на место любого одиозного лидера XX века и нести в массы с трибуны откровенную ересь. Сейчас же в одном из сгенерированных deep fake видео бывший президент Барак Обама позволил себе нецензурные выражения в адрес Дональда Трампа.

Конечно, на первых порах реклама deep fake была исключительно вирусной – лица голливудских актрис имплантировали в незамысловатые сюжеты порнороликов со всеми вытекающими последствиями. Или, например, актер Николас Кейдж неожиданно становится главным актером в эпизодах самых знаковых фильмов современности. Некоторые эти творения представлены на видео и, честно говоря, многие из них выглядят несколько топорно.

А вот хип-хоп-исполнительница Карди Би, которая предстала на вечернем шоу Джимми Фэллона в образе актера Уилла Смита, выглядит вполне убедительно.

А вот оригинал.

Неплохо выглядят поделки на канале Ctrl Shift Face. К например, Сильвестр Сталлоне примерил главную роль в «Терминаторе».

Уже сейчас IT-аналитики заявляют, что «фейковая» технология может стать самой опасной в цифровой сфере за последние десятилетия. В дополнение к этой технологии (и на её основе) спецы из университетов Принстона, Макса Планка и Стэнфорда соорудили приложение Neural Rendering. У него задача еще более опасная – «заставить» изображение человека свои голосом произносить любой текст на любом языке. Для этого требуется всего 40-минутное видео со звуком, в ходе которого нейронная сеть научится работать с голосом и мимикой человека, трансформируя это для новых словесных выражений. Изначально идея, конечно, позиционируется как благая: основным потребителем Neural Rendering станут киностудии, желающие сократить время на съемку актерских дублей. Однако всем сразу же стало понятно, что в недалеком будущем фактически любой пользователь может у себя на ноутбуке генерировать видеофейки, от которых волосы встанут дыбом. Вторым ответвлением «фейковой» программы стало приложение DeepNude, способное достаточно реалистично «раздеть» догола на фотографии любую женщину. В первые дни работы сервиса объем свалившихся запросов был настолько велик, что разработчики в опасении судебных исков объявили о его закрытии. Но хакеры взломали ресурс, и сейчас DeepNude может воспользоваться каждый. Конечно, сервис пытаются ограничить в доступе, но все понимают, что это лишь временная мера.

Deep fake оказался неплохим инструментом в руках мошенников. Одну британскую энергетическую компанию ограбили на 220 тыс. евро, когда на связь с финансовым отделом вышел «клон» управляющего из Германии. Он смоделированным голосом попросил срочно перевести деньги на счет в Венгрии, и у бизнес-партнеров не было ни единого повода не верить абоненту. Конечно, сейчас массово и качественно подделывать видеоряд проблематично – государственные регуляторы постоянно блокируют ресурсы с fakeapp и facefake, да и мощности компьютеров пока не позволяют оперативно синтезировать видео. Приходится перепоручать эту работу удаленным платным серверам, которым для работы требуют тысячи фотографий оригинальной личности и «жертвы».

Сasus belli

Технология deep fake может в будущем оставить актеров без работы – вся индустрия вполне может перейти на «мультяшных» киногероев, многих из которых технология воскресит из мертвых. Но это скорее мечты о будущем, так как многочисленные профсоюзы и элементарная нехватка вычислительных мощностей отодвигает перспективу на несколько лет вперед. Хотя уже сейчас в фильме «Изгой один: Звёздные войны» режиссер для одного эпизода «воскресил» актера Питер Кушинга, скончавшегося в 1994 году. Ходят слухи, что в новом фильме о войне во Вьетнаме может появиться знаменитый Джеймс Дин. Нейросети помогают актерам, которые уже в годах, выглядеть в кадре на 10-20 лет моложе – к примеру, Арнольду Шварценеггеру и Джонни Деппу. В среднем в мире сейчас генерируется не менее 15-20 тыс. deepfake видео каждый месяц, большая часть которых появляется в Интернете. Российские программисты стараются идти в русле мировых трендов — компания Vera Voice в июле 2020 года предложит поклонникам творчества Владимира Высоцкого пообщаться с цифровой копией певца в Театре на Таганке.

Все идет к тому, что видео- и фотодоказательства перестанут быть действенными аргументами в судебных разбирательствах, а глобальная система видеонаблюдения окажется пустой тратой денег. Никто не будет доверять кадрам с камер видеонаблюдения. Где гарантия, что это не синтезированная пустышка? В политической пропаганде deep fake уже сейчас становится мощнейшим рычагом влияния на мнение избирателей. Калифорния в октябре 2019 году стала первым штатом, вообще запретившим выкладывать в сеть ролики с политическими кандидатами за 60 дней и менее до выборов. За нарушение данного закона АВ 730 грозит уголовная ответственность. Сейчас к этой инициативе присоединили еще несколько штатов, а января 2020 года в Китае будет запрещено публиковать синтезированные deep fake фото и видео без особой пометки. Кстати, сейчас одним из действенных приемов определения подделки на глаз является отсутствие естественного моргания у синтезированных персонажей.

А теперь представьте, насколько развитие технологии deep fake (а развитие не остановить, пока будет спрос) перевернет представление о правде и лжи. Особенно когда новинку возьмут на вооружение государственные структуры. Любое синтезированное видео об очередном шпионском разоблачении при умелом использовании может стать поводом как минимум для наложения очередного пакета санкций или закрытия дипломатического представительства. И не нужно будет инсценировать химические атаки на мирных жителей, чтобы санкционировать массированный ракетный удар по суверенному государству. Акты геноцида, последствия применения оружия массового поражения, вызывающее и оскорбительное поведение первых лиц государства – весь этот deepfake букет в нужной ситуации может оправдать в глазах избирателей начало очередной военной авантюры. А когда заговорят пушки и полетят ракеты, никто особо и не будет вспоминать, с какого разоблачающего видео началась война.

Сейчас нет однозначного ответа, что делать с этим бедствием. Лучшие алгоритмы, заточенные на разоблачение deep fake, могут гарантировать лишь 97%-ную вероятность. В настоящее время каждый прогрессивный программист может принять участие в Deepfake Detection Challenge, который в сентябре 2019 года анонсировал Facebook. Призовой фонд в 10 млн. долларов достанется тому, кто сможет разработать алгоритм, позволяющий со 100%-ной гарантией распознавать фейковые видео. Насколько быстро последует ответная реакция от подпольных разработчиков deep fake, остается только гадать.

Информация